25 сентября 2014 года в IT-Park’е в Казани начала свою работу ежегодная конференция по поисковой оптимизации.

Международная конференция SEO Conference проходит в столице Татарстана уже в пятый раз. Постоянными гостями мероприятия являются такие компании, как: Google, ВКонтакте, Mail.ru, Яндекс, Финам, Sape и многие другие. Конференция является уникальной площадкой для бесценного обмена опытом, предоставляет множество возможностей для личного общения, а также для установления полезных бизнес-связей и деловых контактов.

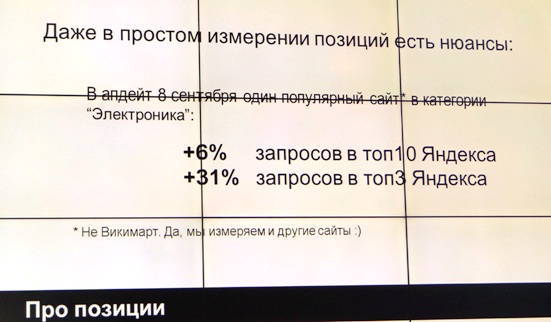

Программную часть для вебмастеров и оптимизаторов продолжил Михаил Сливинский из Wikimart, выступив с докладом «Прикладная поисковая аналитика, или что вы знаете о своем SEO?»

Прежде, чем перейти к основной части своего доклада, спикер отметил, что именно 25 сентября Яндекс начал активную борьбу с накруткой поведенческих, объявив о том, что использование некорректных способов продвижения приводит к существенной потере трафика.

Чтобы спрогнозировать, насколько успешно сайт будет ранжироваться в выдаче, важно осуществлять измерения. При этом измерять следует не только аспекты, напрямую связанные с сайтом - имеет смысл отслеживать целый комплекс различных факторов. А иногда имеет смысл отслеживать и позиции других сайтов.

Если недостаточно интегральных оценок, то придется научиться подавлять «шум»: необходимо смотреть на позиции запросов и научиться отделять значимые измерения от незначимых. А чтобы понять картину в целом, нужно смотреть на несколько метрик. На этом этапе важно производить сравнительный анализ.

В доказательство своих слов Михаил Сливинский привел практический кейс, когда в результате обычной починки микроразметки сайт получил 9,5% дополнительного трафика из Google.

Следует помнить, что на более или менее крупном сайте регулярно что-то ломается. Важно постоянно следить как за техническим состоянием ресурса, так и за состоянием контента. К примеру, имеет смысл регулярно искать дубликаты, т.к. они плохо влияют на индексацию сайта. Находить дубли можно при помощи цитатного поиска по сайту, исключением известных типов страниц, частотным словарем, по URL'ам из accesslog’a или выгрузками из панели вебмастера.

Еще одним показательным примером действий специалиста, приводящих к ухудшению индексации ресурса может стать случайное добавление метатега noindex при очередной выкладке. В результате, сайт, претерпевший такую ситуацию на практике, потерял 13% трафика из Google. Во всех подобных ситуациях докладчик посоветовал использовать статус 503.

Что касается краулинга, то важно уделить особое внимание трафиковым документам и документам с высоким потенциалом по Wordstat.

Также важно постоянно отслеживать появление кодов ответа 404 и пустых лендингов. Наличие данных проблем на сайте негативно влияет на поведенческие факторы, которые нужно каким-то образом улучшать. Важно обеспечить пользователю максимально комфортное взаимодействие со страницей, предложить альтернативные товары и т.п. В ситуации, когда товар. Представленный на странице отсутствует в наличии, резко и мгновенно ухудшаются документные поведенческие факторы, и, следовательно, снижение поискового трафика.

Спикер также отметил, что оптимизаторы часто фиксируются на релевантности. Важно разбить запрос на отдельные слова и постараться найти каждое слово с привязкой к документу.

Также для осуществления аналитики сайта можно использовать специальную таблицу:

В данной таблице по горизонтали можно разместить определённые разделы сайта. По вертикали – трафик сайта. В перекрестье – трафик на каждую из перечисленных категорий.

Подводя итоги, Михаил Сливинский заострил внимание слушателей на том, что не стоит пытаться обмануть поиск. Нужно улучшать сайт, приносить пользу бизнесу и покупателю. В забеге на длинную дистанцию обязательно нужны инструменты мониторинга и культура регулярного анализа. Наконец, необходимо наладить доверительные отношения между заказчиком и оптимизатором.

Секцию продолжил Иван Красюк из компании Kokoc.com. Его доклад носил название: «Глубокая настройка universal analytics до уровня полноценной CRM».

В своем выступлении Иван Красюк затронул вопросы: веб-аналитики в целях повышения эффективности бизнеса. Напомнил, о чем не следует забывать при полной настройке UA. Рассказал, как устроена система Universal Analytics; какие данные можно и нужно импортировать в UA; чем отличается UA в базовой настройке и в полной. Поделился со слушателями идеальной схемой интеграции аналитики в бизнес и обратно.

Известно, что система Universal Analytics позволяет собирать полную информацию о бизнесе и о том, как люди, приходящие в онлайн, делают заказы. Universal Analytics устроена по следующему принципу:

API Universal Analytics имеет смысл использовать, поскольку он обеспечивает:

Автоматизацию получения данных;

Больше двух параметров Google Analytics;

Данные сразу из нескольких профилей;

Данные не в интерфейсе Google Analytics;

Легко выгрузить большой объем данных для анализа;

Быстрое получение данных.

Отличие GA в базовой настройке от полной настройки, по замечанию докладчика является весьма существенным. Обязательные к использованию дополнительные настройки выглядят следующим образом:

Сводки данных (Dashboards)

Аннотации (Annotations)

Пользовательские отчёты и их отправка по почте

Оповещения (Alerts)

Импорт данных (Data Import и Measurement Protocol)

По сути при таком использовании получается набор виджетов и данных.

Ярлыки используются в случаях, когда интересует конкреный набор данных.

Часто оповещениям уделяется мало внимания. Работая с оповещениями важно понимать, если они будут отправлять электронные письма и СМС пользователям каждый день, то со временем их начнут отправлять в спам. Важно наладить отправку отчетов. Это экономит время и повышает эффективность пользования системы.

Завершая выступление, Иван Красюк отметил, что ни одна система веб-аналитики не дает на 100% точные данные. Важно всегда смотреть на данные динамики и применительно к конкретной цели.

Причины возникновения различий могут быть следующими:

Разные системы используют разные типы куки-файлов.

Место размещения тэгов аналитических систем на странице.

Наличие кодов отслеживания на всех страницах.

Разный срок жизни куки-файлов.

Копирование трекинг-кодов на других сайтах. Осознанное воровство или случайные ошибки.

Разные модели сэмплирования данных.

Наличие фильтров в одной из систем.

Частота обработки данных на серверах системы.

Некорректно установленные временные зоны.

Также в GA можно загружать: информацию о реальных оплаченных/доставленных заказах из CRM; данные по стоимости рекламных кампаний через Data Import; информацию о смене статусов по заявкам; сведения о контенте и группировка контента; дополнительные сведения о товарах; пользовательские данные (рейтинг, лояльность, ценность); сведения о рекламных кампаниях и многое другое.

Завершил выступления первого дня доклад Артема Фомичева, WebEffector: «Статистика больших цифр от Эффектора - ПФ, ссылки, усиление - раскрываем результаты продвижений 2014 года. Делайте выводы».

Спикер поделился уникальной статистикой, собранной по итогам анализа сайтов. Всего было проанализировано более 7 тысяч проектов, более 197 тысяч запросов, найдено около 30 ошибок оптимизации. Наиболее распространенные ошибки выглядят следующим образом:

На следующем этапе вывели зависимость позиций запросов от количества ошибок оптимизации. Выяснилось, что при одной критической ошибке у сайта – до 40% шансов попасть в топ-выдачи Яндекса. Что касается статистики относительно Google, то здесь у сайта с такой же ошибкой несколько меньше шансов попасть в топ.

На следующем этапе сравнивали 2 типа стратегии продвижения: с использованием простых арендных ссылок и арендных ссылок и поведенческих факторов. После очистки данных выборка для анализа составила 20 тыс. запросов.

Если бы сайты продвигались только за счёт поведенческих факторов, то процесс попадания сайта в ТОП был бы более затянутым.

Далее сравнивалась зависимость роста от начальной позиции:

Встречаются сайты, которые после работы над ошибками стартуют с 200 места и идут вверх. Это показывает, что за 2 месяца, проделав работу над ошибками, можно вывести сайт в ТОП.

Зависимость скорости продвижения от частотности запроса выглядит следующим образом: высокочастотные запросы медленнее движутся вверх.

Геозависимые запросы растут гораздо лучше, и они более динамичны:

Статистика эффективности продвижения за счет ПФ и ссылок по регионам выглядит так:

Выяснилось также, что коло 4 тыс. сайтов в сутки усиливают ссылки. Более 120 тыс. ссылок в сутки усиливается. За 2 месяца после старта по состоянию на 25 сентября 2014.

Результаты проведённого исследования позволили сделать такие выводы:

Сила зависимости средней позиции от выборки ошибок говорит о первостепенной важности контента на сайте.

По данным аналитики, к концу 2014 года эффект от арендных ссылок не только не уменьшился, но даже возрос по отношению к 2013 году.

Если перед проектом стоит цель быстро (за месяц) и недорого продвинуть несколько низкочастотных и среднечастотных запросов, то лучший вариант – использовать поведенческие факторы + ссылки.

Обсудить

Обсудить

Комментарии