27–28 мая 2014 года в Санкт-Петербурге, в конгресс-центре гостиницы «Прибалтийская Park Inn» прошла IX Санкт-Петербургская интернет-конференция (СПИК-2014). Программными темами этого года стали интернет-маркетинг, веб-аналитика, разработка мобильных приложений, SEO и электронная коммерция.

В этом году мероприятие посетило около 3 тысяч участников: это лидеры интернет-бизнеса северной столицы, эксперты и специалисты по инфокоммуникациям и интернет-технологиям, сотрудники российских IT-компаний, генеральные директора и владельцы компаний, маркетологи, PR-специалисты, копирайтеры, юзабилисты, а также обычные интернет-пользователи и представители СМИ.

СПИК-2014 – это 2 дня, 5 потоков и 200 интереснейших докладов в 40-ка секциях. В рамках секции, под названием SEO-коучинг, выступил Дмитрий Севальнев, руководитель отдела SEO в компании Пиксель Плюс, который представил результаты статистического исследования фильтра АГС-40 в Яндексе. Исследование было проведено с целью поиска закономерностей и корреляции с рядом классических SEO-показателей сайтов. Анализировались данные, собранные на основе пробивки полной базы вечных ссылок.

ВАЖНО: на всех графиках представлены относительные величины (число сайтов под АГС в данной группе к общему числу сайтов в группе)

Для начала нужно хорошо рассмотреть подходы, используемые в поисковых системах для решения двух различных задач: антиспам и ранжирование. Здесь важно понимать, что при ранжировании, при определении качества сайта и его релевантности, и при фильтрации доноров могут играть роль совершенно разные факторы. Так, например, для ранжирования чрезвычайно важны текстовые факторы, для отбора доноров – скорость загрузки. Антиспам и ранжирование учитывают различные метрики и требуют разных подходов.

При решении задач антиспама используются факторы, которые не участвуют в ранжировании. Среди них могут быть:

• CMS-сайта

• Доля роботизированных запросов

• Скорость прироста контента на сайте

• Количество исходящих коммерческих ссылок к числу страниц в индексе поисковой системы

А также оптимизируются свои метрики качества «антиспама». И постоянно ищется баланс точности и полноты (F-мера):

При выкатывании новых санкций и обновлений, поисковыми системами изучается поведение метрик качества поиска (pFound и подобных). Для значительных изменений проводится расчет метрик качества, анализ поведения пользователей на выдаче (пользовательские метрики):

• с разбиением запросов на группы

• замер множества показателей по выдаче

• уход в другие поисковые системы

Прежде, чем оценивать масштаб внедрения нового фильтра АГС для ссылочных бирж и агрегаторов, не лишне вспомнить некоторые факты об АГС – 40.

Новый алгоритм впервые был замечен 1 ноября 2013, когда был АП, после которого из индекса Яндекса вылетело много сайтов, а официально анонсирован 6 ноября в блоге Яндекса для вебмастеров. После этого было замечено несколько «волн» наложения санкций, а также регулярное обновление базы и выход ряда сайтов из-под санкций и попадание под санкций новых. Это позволяет сделать вывод о том, что основная идея АГС состоит в том же, в чем она заключается при фильтрации спама – точность и полнота, т.е. зафильтровать все ГС и не затронуть тех, кто этого не достоин.

После введения АГС – 40, cсылочными биржами были даны различные оценки того, сколько сайтов оказались под фильтром, - от 1% до 20% от всей ссылочной базы. Для того, чтобы поверить это утверждение, было проведено исследование на основе полной базы ссылочной биржи.

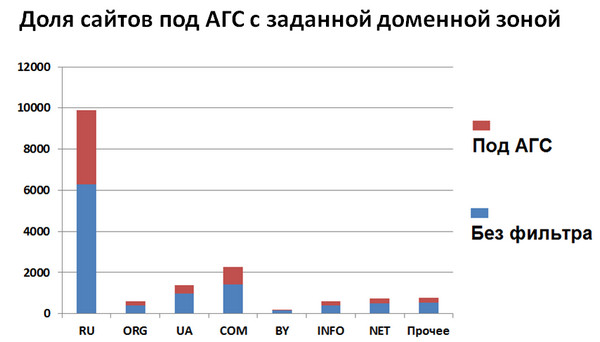

База: 17 744 сайта, при проверке «живых»: 16 442 сайта. При этом, 60% сайтов зарегистрированы в зоне .ru, 14% - в зоне .com, 8% - в зоне .ua, по 4% в зонах .org, .info и .net и 1% - в зоне .by.

Всего попало под АГС-40 35% сайтов, представленных в бирже. То есть, при покупке всех ссылок подряд, можно быть уверенным, что 30% из них, как минимум, не работают.

Большая часть зафильтрованных сайтов расположена в зоне.ru. Не секрет, что в некоторых доменных зонах сайты стоят дешево, и поэтому там генерят много сайтов для заработка, однако, яркой выраженности по доменным зонам нет:

Какие же есть классические SEO-факторы, повышающие и понижающие вероятность наложения фильтра? Как подбирать доноров так, чтобы они не были зафильтрованы?

1. Наличие сайта в каталоге

Исследование показало, что наличие сайта в Яндекс.Каталоге снижает вероятность наличия фильтра в 2,5 раза. Можно даже сказать, что это дает гарантию качества площадки. Среди сайтов, зарегистрированных в YACA, под АГС оказалось всего 10%, а среди сайтов, не попавших под фильтр, 25% наличествуют в Яндекс.Каталоге. В то же время DMOZ снижает вероятность наличия АГС в 5,4 раз, что дает еще большую гарантию, так как среди сайтов под АГС в DMOZ - 3,5%, а среди сайтов без АГС в DMOZ - 19% . А если брать сайты, которые есть и там и там, то они попадают под фильтр в 40 раз меньше, чем те, которые там не находятся. Однако, к сожалению, среди всей ссылочной биржи таких сайтов – только 10%.

2. Торговля ссылками

Далее был рассмотрен ряд доноров, продающих ссылки и не продающих, которые попали под АГС. Выяснилось, что никакой явной зависимости нет, что подтверждает слова Яндекса о том, что он борется не с сайтами, которые продают ссылки, а с теми, которые созданы не для людей.

3. Тип CMS

На каких CMS-ках делают сайты не для людей и для торговли ссылками? Есть мнение, что на дешевых, чтобы если вдруг забанят – не жалко. Решено было проверить это утверждение и посмотреть, есть ли реальная зависимость наложения АГС от типа CMS?

Исследование показало, что среди сайтов, использующих Bitrix самый минимальный процент попал под фильтр АГС (правда и доноров мало). Хороший результат показал также, как ни странно, и UCOZ.

4. Наличие блоков Яндекс.Директа

Очень крутым фактором для определения хорошей площадки оказалось наличие на сайте блоков Яндекс.Директа. Под AГС попало всего 4% таких сайтов. Это во многом обеспечивается тем, что для принятия в рекламную сеть Яндекса существует определенный проект посещаемости, и модераторы постоянно проверяют качество площадок.

5. Возраст сайта

Есть ли влияние возраста домена на вероятность наличия АГС? Всего исследовалось 8 299 сайта. Самую большую долю сайтов, попавших под АГС, составляют сайты возрастом меньше 1 года, и самую меньшую – возрастом свыше 5 лет. 6. тИЦ

Есть ли влияние показатель тИЦ на АГС? Всего исследовалось 16 402 сайта. Исследование показало, что зависимость есть, причем почти линейная!

Вывод – лучше, если среднее значение тИЦ донора где-то в районе 30-40.

7. Посещаемость

Всего исследовалось 6 986 сайтов. Было отмечено резкое падение доли сайтов под АГС после 150 посетителей и после 300 посетителей в сутки. Получается, что если сайт кто-то посещает, то, наверное, он для людей, и это учитывается поисковой системой.

8. Количество исходящих ссылок на страницу

Как сказываются на наложении АГС исходящие ссылки? Всего исследовалось 11 726 сайтов. Исследование выявило общую тенденцию, что увеличение числа исходящих ссылок, в расчете на страницу, увеличивает вероятность попадания под фильтр:

Вывод: если на сайте 100 страниц, и он ссылается на 200 сайтов – это хорошо.

Так как наблюдается корреляция вероятности наложения фильтра АГС с рядом классических SEO-показателей, рекомендации по выбору доноров могут быть следующими:

• Посещаемость площадки от 300 в сутки

Наличие трафика: говорит о пользе сайта, интересе к нему пользователей (желателен непоисковый трафик).

• Наличие в YACA + DMOZ

YACA + DMOZ: ручная модерация сайта, возможно исключение сайта из каталогов после перепроверки.

• Наличие блоков Яндекс.Директа

Яндекс.Директ: ручная проверка + наличие трафика (примерно от 300 пользователей в сутки).

• Площадки на Bitrix и UCOZ…

CMS: косвенный фактор. Платная CMS + платные модули.

• Доноры с … тИЦ от 300

тИЦ: при расчете Яндекс фильтрует входящие ссылки, наличие естественных ссылок также свидетельствует об интересе пользователей к сайту.

Предостережения: если покупать ссылки только с донорами указанных параметров, можно не очень много купить. Нужно иметь в виду, что ссылочная масса должна быть разной, нужно находить доноров и с нулевым тИЦом, и с маленькой посещаемостью. Потому, что ссылки с доноров с тИЦ=0 могут быть также важны, как и ссылки с тИЦ>300.

Факторы антиспама построены также и на анализе анкоров входящих ссылок (анкор-листе). Особое внимание нужно уделять трафику на сайтах-донорах, нормированному на число страниц в индексе (для качества) и общему трафику (для фильтрации).

В ходе исследования также были замечены следующие негативно сказывающиеся факторы на коммерческом сайте:

1. Отсутствие контактов и реквизитов компании.

2. Наличие большого числа бессмысленных («переоптимизированных») или неуникальных статей.

3. Плохое оформление контента (сканы, копипаст и т.д.).

4. Отсутствие обновления сайта длительное время.

5. Плохое окружение (IP-адрес хостинга).

Если сайт все же попал под АГС – есть вероятность вывода и далеко ненулевая:

Обсудить

Обсудить

Комментарии